En marzo del 2022, el fiscal general de Nueva Jersey hizo una pregunta importante al público: ¿cómo se debe regular el uso de la tecnología de reconocimiento facial por parte de los cuerpos policiales? En respuesta, la Unión Americana de Libertades Civiles de Nueva Jersey (ACLU-NJ) urgió al fiscal general a considerar una preocupación más fundamental: ¿se le debería permitir a los cuerpos policiales utilizar el reconocimiento facial? Nuestra respuesta es un rotundo no, y llamamos a una prohibición total del uso de la tecnología de reconocimiento facial por parte de los cuerpos policiales.

Las razones de esto van al corazón de por qué comenzamos nuestro Proyecto de Injusticia Automatizada. La tecnología de reconocimiento facial, como muchos tipos de inteligencia artificial o sistemas de decisión automatizados utilizados por el gobierno, puede empeorar la injusticia racial, limitar nuestros derechos y libertades civiles, como el derecho a la privacidad y la libertad de expresión, y privar a las personas de la justicia fundamental. Si queremos combatir esos daños, el reconocimiento facial no puede escapar de nuestro escrutinio, especialmente porque los cuerpos policiales de Nueva Jersey continúan usando la tecnología a pesar de sus peligros.

Cuando discutimos el uso del reconocimiento facial por parte de los cuerpos policiales, a menudo nos referimos a una acción llamada identificación facial: dada una foto fija de la escena de un crimen, como una tomada de una cámara de vigilancia, la policía compara una cara en la foto con una identidad conocida en una base de datos policial existente, como una colección digital de fichas o de fotos policiales. La tecnología de reconocimiento facial automatiza ese paso de identificación a través de inteligencia artificial.

Esta acción puede parecer bastante básica, pero para comprender cómo el uso de la tecnología de reconocimiento facial agrava vigilancia racista y amenaza nuestras libertades civiles, veamos qué sucede cuando falla el reconocimiento facial y luego consideremos las consecuencias si funcionara demasiado bien.

¿Qué pasa cuando el reconocimiento facial sale mal?

Cuando falla el reconocimiento facial, los errores conducen a un arresto y encarcelamiento injustificado, y las personas de color son las más afectadas.

Ser identificado como un sospechoso potencial puede resultar directamente en arresto y encarcelamiento. Cuando el reconocimiento facial etiqueta un rostro desconocido con una identidad equivocada (un falso positivo), eso puede resultar en un arresto y encarcelamiento injustificado.

"El reconocimiento facial está lejos de ser una ciencia exacta. Los analistas humanos pueden depositar una confianza indebida en la tecnología de reconocimiento facial, creyendo que las coincidencias incorrectas son verdaderas incluso si su propio juicio fuera diferente."

Este problema no es hipotético. Los habitantes de Nueva Jersey ya han sido arrestados debido a que el reconocimiento facial salió mal. Un hombre de Paterson llamado Nijeer Parks pasó diez días en la cárcel por hurto después de que la policía lo identificó erróneamente utilizando reconocimiento facial, a pesar de que estaba a 30 millas de distancia en el momento del incidente. En este caso, la policía subcontrató la búsqueda a través de reconocimiento facial al pedirle a los cuerpos policiales de Nueva York que realizaran la búsqueda utilizando su sistema. Esta práctica no es regulada lo que hace que la supervisión y que la rendición de cuentas sea aún más difícil de implementar.

¿Cómo pueden ocurrir tan fácilmente estos errores obvios? El reconocimiento facial está lejos de ser una ciencia exacta. Los sistemas y algoritmos como el reconocimiento facial todavía requieren que los humanos los operen e interpreten sus resultados, lo que lleva a errores y mal uso. Los analistas humanos pueden depositar una confianza indebida en la tecnología de reconocimiento facial, creyendo que las coincidencias incorrectas son verdaderas incluso si su propio juicio fuera diferente. El resultado es un proceso de investigación propenso a errores que puede conducir a una grave pérdida de libertad.

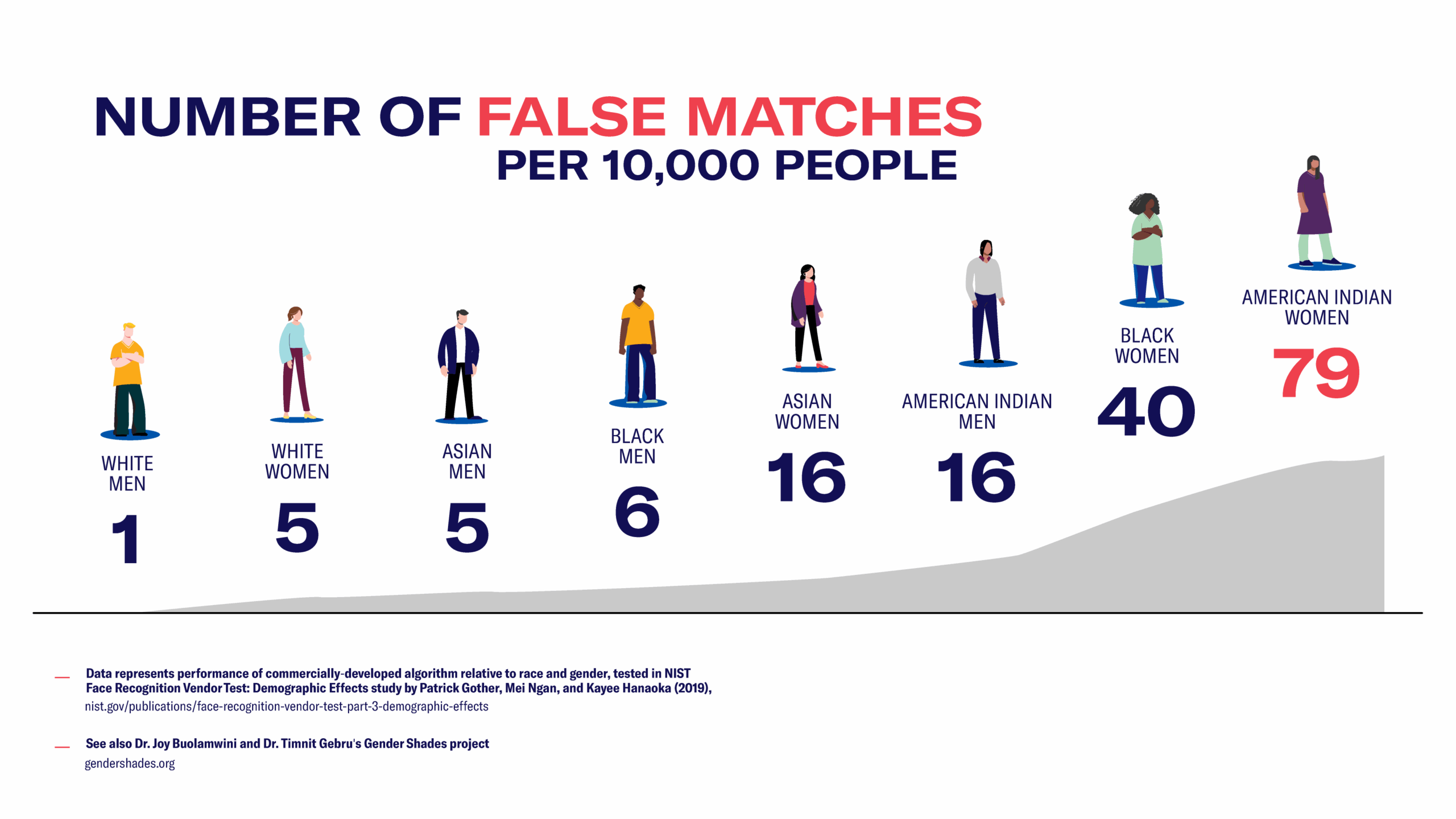

Para agravar esos problemas, las tecnologías de reconocimiento facial suelen ser más propensas a cometer errores cuando intentan identificar los rostros de gente morena, y lo que significa es más probable que las personas de color enfrenten un escrutinio policial erróneo. La desigualdad en el rendimiento puede ser severa: un algoritmo comercial de reconocimiento facial probado por el gobierno era 40 veces más propenso a errores para las mujeres negras y 79 veces más propenso a errores para las mujeres indígenas que para los hombres blancos.1

¿Qué pasa si funcionó el reconocimiento facial con perfecta precisión?

Incluso si el reconocimiento facial identificara a las personas con perfecta precisión, seguiría siendo inadecuado para el uso policial en una sociedad libre.

A nuestros derechos y libertades no les iría mejor en un mundo donde las tecnologías de reconocimiento facial fueran 100 por ciento precisas. Incluso si el reconocimiento facial fuera igualmente preciso para las personas blancas que para las personas Negras, las herramientas policiales y de vigilancia todavía están dirigidas de manera desproporcionada a las comunidades de color, lo que genera daños mayores para esas comunidades.

"Un algoritmo comercial de reconocimiento facial probado por el gobierno era 40 veces más propenso a errores para las mujeres negras y 79 veces más propenso a errores para las mujeres indígenas que para los hombres blancos."

Y en un nivel fundamental, la presencia de vigilancia altera la relación de las personas con sus vecindarios y comunidades. El uso generalizado del reconocimiento facial puede tener un efecto negativo sobre la libertad de expresión y asamblea si las personas temen perder su anonimato cuando participan en actividades políticas protegidas por la Primera Enmienda. La amenaza de la vigilancia y el escrutinio del gobierno puede incluso desalentar lo que deberían ser actividades cotidianas básicas, como ir a una clínica de salud o a un templo de adoración. La necesidad de una prohibición total del reconocimiento facial por parte de los cuerpos policiales. La única política segura para gobernar el reconocimiento facial es la prohibición total de su uso por parte de los cuerpos policiales.

La necesidad de una prohibición total del use del reconocimiento facial por parte de los cuerpos policiales

La única manera segura de regular el reconocimiento facial es una prohibición total del uso por parte de los cuerpos policiales.

Los habitantes de Nueva Jersey ya están rechazando esta tecnología invasora – en 2021, Teaneck se convirtió en la primera ciudad de Nueva Jersey en prohibir que la policía use el reconocimiento facial, en gran parte debido a las preocupaciones sobre el efecto de la tecnología en los derechos civiles. Y en enero de 2020, el fiscal general de Nueva Jersey prohibió el uso de la poderosa e intrusiva herramienta desarrollada por Clearview Al. Exhortamos a los habitantes de Nueva Jersey que pregunten a las autoridades locales sobre el uso del reconocimiento facial y exijan mayor supervisión de esta tecnología peligrosa y poco confiable.

Los sistemas policiales no son el único contexto en el que el gobierno utiliza el reconocimiento facial: todo, desde la seguridad escolar hasta los beneficios públicos, podría verse afectado por la adopción del reconocimiento facial. Es importante que permanezcamos atentos al uso del reconocimiento facial y sigamos pidiendo regulación y supervisión para defender los derechos y libertades civiles fundamentales.

La ACLU-NJ comenzó el Proyecto de Injusticia Automatizada para investigar el uso de inteligencia artificial, sistemas automatizados de toma de decisiones y otros tipos de algoritmos por parte del gobierno de Nueva Jersey. Te invitamos a compartir tu historia de cómo el uso de sistemas automatizados por parte del gobierno ha afectado tu vida.